Kịch bản lừa đảo mới chưa từng xuất hiện, mất 15 tỷ trong 10 phút dù "mắt thấy, tai nghe"

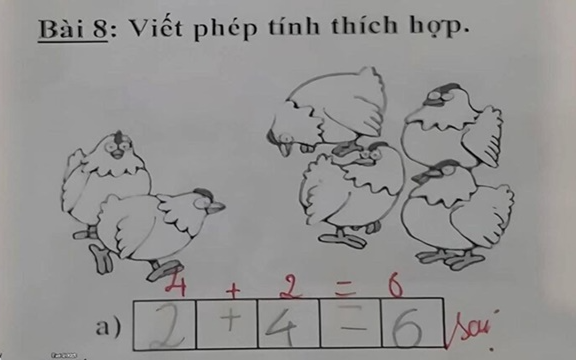

Những người càng lớn tuổi càng trở thành đối tượng mà những kẻ lừa đảo này nhắm đến.

Chuyên trang Đời sống & Pháp luật ngày 11/11/2025 đưa tin: "Kịch bản lừa đảo mới chưa từng xuất hiện, mất 15 tỷ trong 10 phút dù "mắt thấy, tai nghe"", cho biết vụ việc xảy ra như sau:

Công nghệ AI đang khiến những chiêu trò lừa đảo trở nên tinh vi hơn bao giờ hết.

Theo tờ QQ đưa tin, nạn nhân họ Quách - giám đốc của một công ty công nghệ tại Phúc Châu (Trung Quốc). Lúc này, vào khoảng 11h trưa, ông Quách bất ngờ nhận được cuộc gọi video qua WeChat (MXH phổ biến ở Trung Quốc) từ một người bạn thân.

Trong cuộc trò chuyện kéo dài khoảng 10 phút, người bạn này cho biết đang tham gia đấu thầu dự án ở xa, cần gấp 4,3 triệu NDT (khoảng 15 tỉ đồng) để làm tiền bảo đảm dự thầu. Người này nói rằng theo quy định, khoản tiền đó phải được chuyển từ tài khoản công ty sang tài khoản công ty, nên muốn nhờ ông Quách cho mượn tạm tài khoản doanh nghiệp của mình để “làm thủ tục cho đúng quy trình”.

Kết thúc cuộc gọi, người bạn này liền gửi ảnh chụp chứng từ chuyển khoản ngân hàng và nhắn qua WeChat rằng đã chuyển tiền vào tài khoản của ông Quách. Tin tưởng vì vừa trò chuyện trực tiếp qua video và thấy mặt cùng giọng nói y hệt bạn mình, ông Quách không kiểm tra lại số dư mà ngay lập tức chuyển tổng cộng 4,3 triệu NDT, chia làm 2 lần, vào tài khoản mà người bạn này cung cấp.

Chỉ đến khi ông Quách nhắn tin báo "xong rồi" nhưng điều kỳ lạ là người bạn này lại phản hồi bằng 1 dấu chấm hỏi thì mọi chuyện mới vỡ lẽ. Gọi điện kiểm tra thì mới hay người kia hoàn toàn không hề nhờ chuyển tiền, chưa từng nhờ vay tiền hay nhờ chuyển khoản gì cả.

Lúc đó, ông mới sững sờ nhận ra mình vừa trở thành nạn nhân của một vụ lừa đảo.

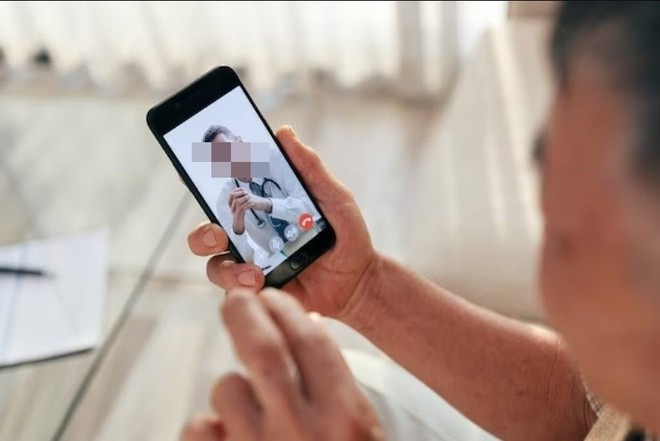

Ông Quách sau đó đã báo cảnh sát thành phố. Cảnh sát sau đó xác nhận: kẻ lừa đảo đã chiếm quyền hoặc giả mạo tài khoản WeChat của người bạn, rồi dùng công nghệ AI đổi mặt và mô phỏng giọng nói để thực hiện cuộc gọi video deepfake. Tức là, dù ông Quách nhìn thấy và nghe thấy “bạn thân” nói chuyện trực tiếp, toàn bộ hình ảnh và âm thanh ấy đều là giả mạo trong thời gian thực.

Phía cơ quan chức năng cho biết thêm rằng nhóm tội phạm đã dùng AI tổng hợp khuôn mặt, biểu cảm và giọng nói của người thật chỉ trong vài phút, khiến việc phân biệt thật - giả gần như bất khả thi. Đây là một dạng deepfake video call, chiêu thức mới đang lan rộng trên WeChat và các nền tảng nhắn tin phổ biến ở Trung Quốc. Đồng thời, phía cảnh sát cũng đã phối hợp với ngân hàng để kích hoạt cơ chế khẩn cấp “ngăn chặn giao dịch”. Nhờ phản ứng nhanh, họ đã thu hồi được khoảng 3,36 triệu nhân dân tệ (tương đương hơn 11 tỷ đồng), nhưng hơn 930.000 tệ (khoảng 4 tỷ đồng) vẫn bị chuyển đi và đang tiếp tục truy vết.

Ngay sau đó, các trang tin truyền thông đồng loạt cảnh báo về “làn sóng lừa đảo bằng AI”, đồng thời ghi nhận thêm nhiều vụ tương tự.

Theo tờ Sohu, tại thành phố Thường Châu (Giang Tô, Trung Quốc) ghi nhận vụ việc một nam thanh niên tên Tiểu Lưu bị kẻ gian giả mạo giọng nói và gọi video WeChat đóng vai bạn học cũ để mượn tiền. Thấy bạn xuất hiện trong cuộc gọi, Tiểu Lưu tin là thật và chuyển ngay 6 nghìn nhân dân tệ (khoảng 22 triệu đồng) cho kẻ lừa đảo.

Cũng theo trang tin này thì đây không phải vụ việc cá biệt. Chỉ trong vài tháng gần đây, nhiều nạn nhân ở Nội Mông Cổ, Tứ Xuyên, Chiết Giang… cũng bị lừa theo chiêu tương tự. AI giả giọng, đổi mặt, gọi video để tạo lòng tin rồi yêu cầu chuyển khoản gấp. Một số vụ việc còn sử dụng công cụ AI sẵn có trên thị trường, chỉ mất vài chục USD và vài phút là có thể “tạo ra khuôn mặt người khác”.

AI voice cloning (nhái giọng nói) và AI face-swapping (đổi mặt) đang được tội phạm mạng khai thác triệt để. Chúng thu thập giọng nói từ các cuộc gọi, clip mạng xã hội, rồi dùng phần mềm tổng hợp để dựng lại giọng nói và biểu cảm như thật, sau đó gọi video qua WeChat hoặc các ứng dụng nhắn tin khác để đánh lừa nạn nhân.

Theo Hiệp hội Internet Trung Quốc, tội phạm đã lợi dụng AI deepfake để giả mạo người thân hoặc bạn bè, tự động tạo video "nói chuyện" nhằm lừa đảo. Các chuyên gia an ninh mạng cũng nhấn mạnh: “Trong kỷ nguyên AI, ‘mắt thấy tai nghe’ chưa chắc là thật. Xã hội cần học cách nghi ngờ có chọn lọc và xác thực thông tin qua kênh chính thức trước khi tin hoặc chuyển tiền.”

Lúc này, nhiều người có kinh nghiệm hay từ phía các cơ quan chức năng cũng đã đưa ra những lời khuyên, cảnh báo để người dân tránh "sập bẫy" kẻ gian.

"Không chia sẻ hình ảnh, video, clip cá nhân lên mạng một cách công khai, vì có thể trở thành nguyên liệu cho công nghệ deepfake.

Không chuyển tiền chỉ dựa trên cuộc gọi video, dù người xuất hiện có là người thân hay bạn bè, mà nên gọi xác minh qua nhiều kênh khác nhau (ví dụ gọi lại bằng số điện thoại, hỏi thêm chi tiết mà chỉ người thật biết).

Khi phát hiện dấu hiệu bất thường, cần báo ngay cho cơ quan công an hoặc ngân hàng để kịp thời chặn giao dịch", tờ Sohu bình luận thêm trong bài viết cảnh báo dùng AI, lừa đảo qua mạng xã hội, chủ yếu ở đây là Wechat.

Trước đó, tạp chí Nhịp sống Thị trường từng đăng bài: "Trò lừa đảo mới, 15 tỷ đồng bị chuyển đi chỉ trong 10 phút, tỷ lệ lừa đảo thành công gần 100%", cho biết về kiểu lừa đảo mới với tỷ lệ lừa đảo thành công gần 100%.

Theo China News, đã từng có lúc, chúng ta nghĩ rằng lừa đảo viễn thông là chuyện xa vời, thủ đoạn của kẻ gian vụng về đến mức chỉ cần một chút cảnh giác là có thể phát hiện. Tuy nhiên, sự phát triển của công nghệ là con dao hai lưỡi. Trong khi mang lại tiện lợi, nó cũng bị những kẻ xấu lợi dụng để sinh ra các hình thức lừa đảo mới tinh vi và khó nhận biết hơn – lừa đảo bằng trí tuệ nhân tạo (AI).

Khác với những phương thức lừa đảo truyền thống tốn nhiều thời gian, công đoạn phức tạp, lừa đảo bằng AI nhờ vào tính hiệu quả và độ chính xác cao có thể gây ra tổn thất kinh tế lớn chỉ trong thời gian cực ngắn, khiến người ta không kịp trở tay.

Giữa năm 2023, Sở Công an thành phố Bao Đầu, Nội Mông (Trung Quốc) đã công bố một vụ án lừa đảo sử dụng công nghệ AI.

Vào ngày xảy ra vụ việc, ông Quách – giám đốc một công ty công nghệ địa phương – bất ngờ nhận được lời mời gọi video trên mạng xã hội từ một người bạn thân. Khi ông bắt máy, người bạn cho biết đang ở nơi khác để tham gia đấu thầu, cần gấp 4,3 triệu NDT(khoảng 15 tỷ đồng) làm tiền đặt cọc và hứa sau khi xong sẽ lập tức trả lại.

Vì là bạn thân và lại là gọi video trực tiếp, ông Quách không chút nghi ngờ, lập tức chuyển khoản số tiền khổng lồ 4,3 triệu NDT vào tài khoản mà “người bạn” cung cấp. Dù thấy tên chủ tài khoản không phải là bạn mình, ông vẫn không mảy may nghi ngờ, bởi trong cuộc gọi video, “bạn” ông đã giải thích đây là tài khoản của người khác.

Sau đó, để xác nhận việc đã chuyển tiền, ông Quách gọi điện cho người bạn thật – người này tỏ ra vô cùng ngạc nhiên. Lúc đó ông Quách mới nhận ra mình đã bị lừa. May mắn là ông đã kịp thời gọi báo công an và ngân hàng, chặn được 3,3684 triệu NDT, nhưng 930.000 NDT còn lại đã bị chuyển đi, rất khó thu hồi.

Toàn bộ quá trình ông Quách bị lừa chỉ diễn ra chưa đầy 10 phút. Nếu ông không gọi điện xác nhận ngay hoặc không báo công an kịp thời, tổn thất sẽ còn lớn hơn nữa.

Trong thời gian gần đây, Trung Quốc đã ghi nhận các vụ lừa đảo bằng AI. Một nhân viên tài chính ở Thượng Hải đã nhận cuộc gọi video từ “sếp” mình và bị lừa mất 1,5 triệu NDT. Hay một người đàn ông họ Trần ở Ôn Châu, tỉnh Chiết Giang (Trung Quốc) sau khi gọi video với một cô gái quen qua mạng đã bị đối phương lấy dữ liệu khuôn mặt, sau đó dùng AI ghép mặt anh vào các video để tống tiền.

Từ những vụ việc trên có thể thấy, bất kể bạn là giám đốc thu nhập cao hay người dân bình thường, đều có thể trở thành nạn nhân. Những vụ việc này là hồi chuông cảnh báo rằng lừa đảo AI không còn là mối đe dọa xa vời, mà là cái bẫy ngay trước mắt.

Điều đáng lo ngại hơn nữa là, trong thời đại bùng nổ nền tảng video ngắn hiện nay, rất nhiều người thường xuyên chia sẻ cuộc sống hàng ngày, lộ mặt là chuyện bình thường. Những điều này lại giúp cho kẻ gian dễ dàng thu thập thông tin khuôn mặt và giọng nói của bạn, khiến việc lừa đảo trở nên cực kỳ đơn giản.

Theo dữ liệu từ các cơ quan chức năng Trung Quốc, tỷ lệ thành công của lừa đảo AI rất cao, gần như không ai có thể thoát. Nguyên nhân chủ yếu là vì công nghệ AI hiện nay có thể mô phỏng người thật một cách cực kỳ chân thực, từ giọng nói đến gương mặt, đủ để đánh lừa cả những người cảnh giác cao.

Trước tình trạng lừa đảo AI ngày càng hoành hành, trước hết, cần bảo vệ thật tốt thông tin cá nhân của mình. Đừng tùy tiện chia sẻ những thông tin nhạy cảm như địa chỉ nhà, ngày sinh, họ tên, số CMND/CCCD, tài khoản ngân hàng hay mã xác nhận. Các dữ liệu sinh trắc như khuôn mặt hay dấu vân tay cũng tuyệt đối không nên cung cấp cho người lạ hoặc những phần mềm không rõ nguồn gốc, không có quyền truy cập.

Trên các nền tảng công khai mà ai cũng có thể xem được, càng không nên chia sẻ quá mức ảnh hoặc video của bản thân – đặc biệt là hình ảnh và video có chuyển động – vì những tư liệu này rất dễ bị kẻ gian khai thác để tạo video giả mạo bằng công nghệ AI.

Nếu gặp tình huống bạn bè mượn tiền hoặc người thân cần ứng cứu khẩn cấp, hãy luôn ghi nhớ nguyên tắc 14 chữ: “Xác minh nhiều lớp, kiểm tra danh tính, không cả tin, kiểm tra kỹ.”

Nếu có người tự xưng là người thân hay cấp trên của bạn, yêu cầu bạn chuyển khoản hoặc cung cấp thông tin cá nhân, nhất định phải xác minh qua nhiều kênh như gọi điện, video call hoặc gặp trực tiếp – tuyệt đối không tin tưởng vào một kênh liên lạc duy nhất. Đặc biệt khi gọi video, hãy quan sát kỹ các dấu hiệu bất thường như hình ảnh mờ, giọng nói bị giật lag…

Đồng thời, không được tùy tiện bấm vào các đường link lạ, cài đặt phần mềm không rõ nguồn gốc hay kết bạn với người không quen biết, tránh để thiết bị bị xâm nhập và thông tin cá nhân bị đánh cắp.

Đối với người lớn tuổi trong gia đình – nhóm dễ bị lừa nhất – cần chủ động hỗ trợ họ hiểu hơn về công nghệ AI, thường xuyên trò chuyện và nhắc nhở để nâng cao cảnh giác.

Cuối cùng và cũng là điều quan trọng nhất: Nếu không may bị lừa, hãy ngay lập tức gọi báo công an và liên hệ ngân hàng để phong tỏa giao dịch. Chỉ có hành động kịp thời mới có thể giúp bạn giành lại được phần nào tài sản.